[경고] 아래 글을 읽지 않고 "재미나는 정보량의 정의"를 보면 바보로 느껴질 수 있습니다.

1. 확률2. 이항 분포

(1)

(1)

(2)

(2)

(3)

(3)

(4)

(4)

[정보 기술의 아버지: 섀넌]

통신 이론(communication theory)의 기반을 이루는 정보 이론(information theory)은 식 (1)과 같은 단순한 공식으로 시작한다.

(1)

(1)

여기서 $E$는 임의의 사건(event), $p(E)$는 $E$가 일어날 확률(probability)이다. 식 (1)은 섀넌Claude Elwood Shannon(1916–2001)이 1948년섀넌 32세, 대한민국 정부 원년에 제안한 정보량(information content)의 정의이다[1]. 단순한 로그 함수(logarithmic function)로 구성된 정보량을 기반으로 통신 이론의 감초인 식 (2)의 섀넌–하틀리 정리(Shannon–Hartley theorem)[1]를 엄밀하게 유도할 수 있다는 사실은 수학의 위대한 힘을 보여준다.

(2)

(2)

여기서 $C$는 채널 용량(channel capacity)[단위: bps(bit per second) 혹은 bit/s], $B$는 채널의 대역폭(bandwidth)[단위: Hz], $S/N$은 신호대 잡음비(SNR: Signal-to-Noise Ratio)이다. 섀넌이 천재라 불리고 위대한 이유는, 비트라는 말이 거의 처음 생겼을 무렵[1943년 즈음 투키(John Wilder Tukey)가 제안] 이미 장래의 정보 기술(information technology, IT)에 필요한 거의 모든 이론을 이미 완성했기 때문이다. 섀넌이 논문을 완성한 해는 1944년섀넌 28세, 일제 식민지 시절이지만, 대중에게 공개된 해는 1948년이다[1], [4].

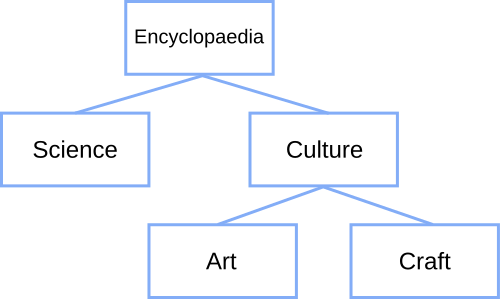

[그림 1] 영국산 불독(출처: wikipedia.org)

섀넌이 식 (1)처럼 정의한 이유를 생각한다. 조금만 생각해보면 알지만 섀넌 정의는 스무고개(twenty questions)와 동일하다. 스무고개는 예, 아니오만 답할 수 있는 질문을 상대방에게 계속해서 특정 사물을 찾아내는 놀이이다. 여기서 예-아니오 질문(yes-no question)은 베르누이 시행(Bernoulli trial)의 대표적인 사례이다. 예를 들어, 내가 생각하는 답이 [그림 1]과 같이 개인 경우 상대방은 아래와 같은 질문을 해서 답을 맞출 수 있다.

- 살아있습니까? 예 → 생물이군.

- 식물입니까? 아니오 → 동물이군.

- 집에서 키웁니까? 예 → 가축이군.

- 새끼를 낳습니까? 예 → 포유류군.

- 어린이보다 키가 작은가요? 예 → 개나 고양이군.

- 개입니까? 예, 맞았습니다.

이런 질문을 통해 개라는 답을 찾은 경우 이 답의 정보량은 얼마인가? 여기에 대한 수학적인 답이 식 (1)이다. 예, 아니오만 답할 수 있음은 이진수(binary number)인 비트(binary digit, bit)를 의미한다. 위에 제시한 스무고개에서 6번의 질문만에 답을 맞추었으므로 정보량은 6비트이다. 이 개념을 일반화한다. 어떤 사건이 발생하고 이 사건의 정보량을 알기 위해서는 스무고개를 해야한다. 어떤 사건이 자주 일어난다면 몇 번 질문할 필요없이 쉽게 답을 맞출 수 있고 아주 드물게 일어난다면 많은 질문을 해야 답을 찾을 수 있다. 그래서 섀넌도 답을 얻기 위해 예 혹은 아니오 질문을 하는 평균 회수를 정보량으로 정의했다. 예를 들어, 개는 흔한 동물 이름이기 때문에 스무고개에 등장하면 쉽게 답을 맞출 수 있지만, 내가 생각하는 답이 생전 처음 들어보는 원소인 운운셉튬(Ununseptium)이라면 답을 맞추기가 매우 어렵다. 이로 인해 정보량이라는 개념은 희소성(rareness), 놀라움(surprise), 불확실성(uncertainty), 무작위성(randomness)과 밀접한 관계가 있다. 그래서 정보량을 쉽게 설명하는 용어로 놀람도(surprisal)를 쓰기도 한다. 이 개념과 함께 확률의 초보적 정의를 본다.

(3)

(3)

여기서 $N$은 일어날 수 있는 모든 경우의 수[혹은 전사건(全事件, total event)의 개수], $n$은 사건 $A$가 발생하는 경우의 수이며, 모든 사건은 공평하게 발생한다고 가정했다. 식 (3)에서 $n$이 작아질수록 희소성이 있으며 놀라우며 불확실성이 증가함을 알 수 있다. 식 (3)을 식 (1)에 대입하여 보기 편한 형태로 만든다.

(4)

(4)

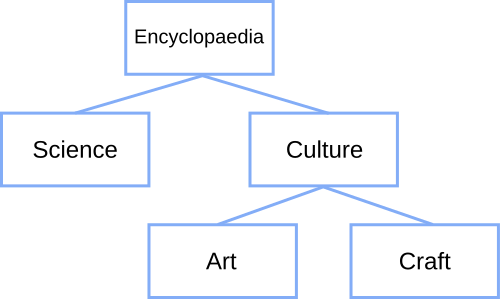

즉, 스무고개와 마찬가지로 [그림 2]와 같이 예 혹은 아니오를 통해[혹은 이분법을 통해] 나눌 수 있는 가지수[혹은 비트수]를 정보량으로 정한다.

정보량 개념의 또 다른 관점은 정보 표현의 효율화이다. 스무고개로 많은 질문을 해야 하는 정보는 자주 나오지 않아서 길게 표현하고, 간단한 질문으로 답은 얻는 정보는 짧게 나타냄으로써 평균적인 정보 표현의 길이를 최대한 짧게 하는 방식을 상상할 수 있다. 이 절차의 정점에 있는 멋진 생각이 바로 평균 정보량인 엔트로피(entropy)이다.

[그림 2] 트리(tree) 구조(출처: wikipedia.org)

[그림 2]에 보인 여러 경우 중에서 베르누이 시행(Bernoulli trial)인 예-아니오 질문으로 정확한 답을 찾을 수 있는 확률이 바로 그 대상이 가진 정보량이다. 이 정보량은 단순하고 직관적이면서도 정말 멋진 개념이다.

정보량을 식 (1)로 정한 또 다른 관점은 확률의 공리이다. 특정 사건에서 정보가 얼마나 많은지를 정량적으로 평가하는 방식은 사건의 확률과 매우 닮아있다.

- 모든 사건에 대해 $I(E) \ge 0$: 정보량은 양이라서 0보다 작을 수 없다. 이는 확률이 항상 0과 1 사이에 있다는 공리와 동일하다.

- 독립 사건(independent event) $E_1, E_2$에 대해 $I(E_1 \cap E_2)$ = $I(E_1) + I(E_2)$: 서로 관계없이 발생하는 사건의 정보량은 당연히 각 정보량의 합으로 표현되어야 한다. 이 개념은 독립 사건의 확률 계산과 동일하므로, 정보량은 꼭 확률로 표현되어야 한다. 더구나 $p(E_1 \cap E_2)$ = $p(E_1) p(E_2)$인 결과로 인해 정보량은 확률과 함께 로그 함수(logarithmic function)가 반드시 도입된다.

특히 독립 사건에 쓰이는 조건부 확률(conditional probability)은 정보량을 통신과 연결시키는 핵심 도구가 된다.

[참고문헌]

[1] C. E. Shannon, "A mathematical theory of communication", Bell System Tech. J., vol. 27, pp. 379–423, 623–656, Jul., Oct. 1948.

[2] 권동승, 나지현, "전자기 정보이론 연구 동향", 전자통신동향분석, 제39권, 제6호, pp. 67–78, 2024년 12월.

[3] T. Wang, Z. Kang, T. Li, Z. Chen, S. Wang, Y. Lin, Y. Wang, and Y. Yu, "Electromagnetic information theory: Fundamentals, paradigm shifts, and applications," arXiv:2503.06651, Mar. 2025.

[4] 지미 소니, 저글러, 땜장이, 놀이꾼, 디지털 세상을 설계하다: 세상을 바꾼 괴짜 천재의 궁극의 놀이본능, 곰출판, 2020년.

[다음 읽을거리]

정보이론쪽 글은 이제 안올리시나요??

답글삭제통신쪽 글을 쓸 때는 식 (2)를 처음부터 끝까지 엄밀하게 증명하는 것이 목표였는데요, 요즘 시간이 안 나서 못 하고 있어요. 언젠가 기회가 되겠죠.

삭제안녕하세요, 섀넌의 채널용량 이야기 뒷부분이 궁금한데 이 글을 계속 연재하실 생각은 없으신가요??

답글삭제안녕하세요, soohwan님. ^^ 죄송하게도 아직까지는 계획이 없어요.

삭제